評分者間信度(inter-rater reliability),是評鑑兩位以上的評分者對同一個標的給予評估結果的吻合程度,當評估結果屬於等距尺度(interval scale)或比例尺度(ratio scale)時,通常會使用組內相關係數(intra-class correlation, ICC);而當評估結果屬於名義尺度(nominal scale)時,則會考慮使用Kappa統計量來評鑑。

以下是某投信公司採用兩種系統進行客戶投資風險承受的評估結果,現在我們想要瞭解這兩個系統的一致性表現為何,採用Kappa統計量進行分析,得到Kappa = 0.666(p < .001)。

|

|

|

系統B |

||

|

系統A |

類型 |

保守型 |

平衡型 |

積極型 |

|

保守型 |

75 |

4 |

1 |

|

|

平衡型 |

5 |

20 |

7 |

|

|

積極型 |

5 |

10 |

30 |

|

在傳統的Kappa分析裡,當兩個評分者對於同一個標的只有在評估結果一樣時才算一致,只要結果不同就當成不一致,來計算Kappa統計量。不過當評估結果能夠視為順序尺度(ordinal scale)時(如本例),我們會覺得「一系統評為保守型,另一系統評為平衡型」,或「一系統評為平衡型,另一系統評為積極型」,似乎都較「一系統評為保守型,另一系統評為積極型」一致性的程度較高,若有這方面的考量,則可以採用加權Kappa(Weighted Kappa),會使較接近的評估結果給予較大的權數,使得結果更為一致,以下將提供兩種方法供大家參考。

方法一:使用語法(syntax)

(1)首先進入『https://www-304.ibm.com/support/docview.wss?uid=swg21477357』

(2)複製該網頁所提供的語法,從『* Read in the IxI matrix of counts for I-level scale.』一直到『end matrix.』

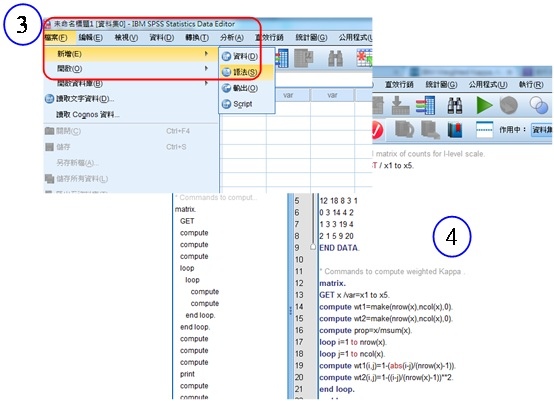

(3)開啟SPSS程式,點選『檔案』→『新增』→『語法』

(4)將(2)複製的語法貼到該語法檔裡

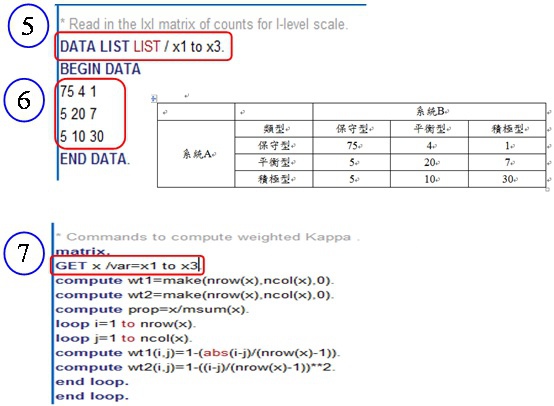

(5)開始修改語法,首先定義有幾個評估水準,本例為保守型、平衡型、積極型共三個,因此改成x1 to x3

(6)將資料的次數以交叉表的矩陣形式輸入

(7)同(5),改成x1 to x3

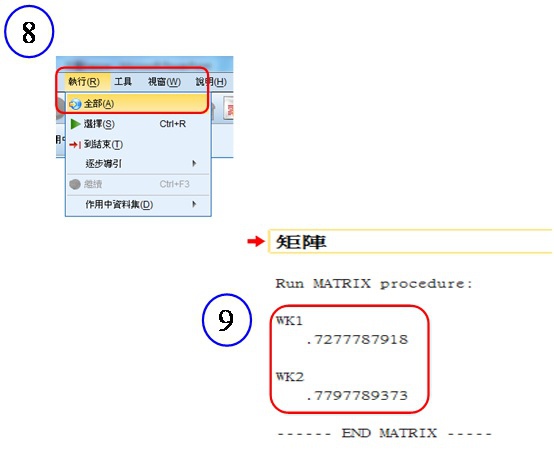

(8)點選上方的『執行』→『全部』

(9)此時報表會給予2個加權Kappa係數,其中WK1屬於線性加權,WK2屬於平方加權,平方加權會較線性加權使更接近的評估結果有更高的權重

留言列表

留言列表

{{ article.title }}

{{ article.title }}