CatBoost(Category Boosting)是由俄羅斯搜索引擎Yandex於2018年開源的一個基於梯度提升(Gradient Boosting)的機器學習演算法。該演算法主要針對分類數據(categorical data)的處理進行了優化,特別在處理稀疏數據和高維度分類數據時展現了出色的性能。它是目前業界較為流行的提升方法之一,被廣泛應用於許多機器學習和數據科學領域。

- 1月 13 週一 202511:47

CatBoost演算法介紹

CatBoost(Category Boosting)是由俄羅斯搜索引擎Yandex於2018年開源的一個基於梯度提升(Gradient Boosting)的機器學習演算法。該演算法主要針對分類數據(categorical data)的處理進行了優化,特別在處理稀疏數據和高維度分類數據時展現了出色的性能。它是目前業界較為流行的提升方法之一,被廣泛應用於許多機器學習和數據科學領域。

- 11月 18 週一 202408:58

SHAP 值在機器學習的應用

在當前的人工智能(AI)和機器學習(ML)領域,模型的透明性與可解釋性愈加重要。隨著這些模型廣泛應用於決策過程中,從醫療診斷到金融風險評估,理解模型如何做出決策變得至關重要。SHAP(SHapley 加法解釋)值因此應運而生,旨在滿足這一需求。SHAP 值是一種基於合作博弈論的解釋方法,它將模型的輸出分解為各個特徵的貢獻,幫助用戶更好地理解模型的運行機制。

- 10月 07 週一 202409:06

機器學習與統計學的優質資源推薦

在數據科學和人工智慧迅速發展的今天,機器學習和統計學已成為各行各業中的重要技能。不過,這些領域的學習資源繁多且分散,對於初學者而言,選擇適合的學習平台和內容至關重要。本文將推薦兩個極具價值的學習資源:吳恩達教授的機器學習課程和YouTube頻道「StatQuest with Josh Starmer」,這些資源將幫助讀者更系統地掌握機器學習和統計學的基礎知識和實踐技能。

一、吳恩達教授的機器學習課程

- 12月 18 週一 202308:59

隨機森林概念與操作:探索強大的機器學習演算法 (2)

- 11月 27 週一 202308:49

隨機森林概念與原理介紹:探索強大的機器學習演算法 (1)

隨機森林是當今機器學習領域中一種強大的演算法,廣泛應用於資料科學和預測建模。它是一種集成學習方法,通過在大量的決策樹之間進行投票,來執行分類和回歸分析。隨機森林的概念和操作靈活性使其成為資料科學家和機器學習實踐者的首選之一。隨機森林採用了決策樹的優點,如解釋性和穩健性,同時克服了決策樹的過擬合(Over-fitting)問題。它通過隨機選擇特徵和訓練樣本,並將它們組合成強大的分類器或回歸器,建立一系列不同的決策樹。這樣,隨機森林能更好地處理複雜的資料集和高維度特徵。

- 12月 05 週一 202209:08

學習網站推薦(機器學習與統計學)

網路上有許多機器學習的課程與資源,筆者想跟讀者分享兩個個不錯的學習資源,供對機器學習有興趣的讀者可以自主學習。

1.吳恩達老師的機器學習課程

- 4月 11 週一 202208:50

在文章中如何引用SPSS與AMOS

當研究所寫的文章是要用來投稿時,除了需要提到所使用的軟體以外,另外也要針對軟體的部分加以說明,包含軟體的版本,發行時間,機構名稱,以及城市/國家,因為最近剛好遇到客戶有這方面的需求,所使用的軟體為SPSS與AMOS,我想大家的版本應該都有所不同,因此搜集了一下資料,分享給大家做使用。

- 8月 23 週一 202109:12

量表分數應用:計算總分or平均(二)

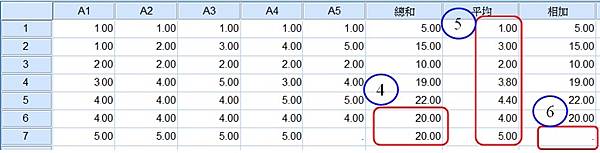

下圖是計算出來的結果,分別得到了總和、平均、相加

(4)採用函數加總時最大的問題是不能有遺漏值,否則計算出來的得分會有偏差問題,以6號受訪者來說,五個題項的回答皆為滿意(4分),總分得到20分,7號受訪者前四題皆回答非常滿意(5分),但由於第五題遺漏,被當成0分來計算,使得這兩名受訪者算出來的滿意程度相等,這樣似乎就不合理了,所以有遺漏值的資料就得特別注意;另外還存在一個問題,若今天研究者想要進行構面之間的分數比較或排序時,以加總分數比較就會出現一個明顯的問題,題數越多分數通常會越高,因此當構面的題數不相同時,就無法在同一個基礎點上做比較。為了解決這兩項問題,個人最推薦採用函數平均進行計算

- 8月 09 週一 202108:54

量表分數應用:計算總分or平均(一)

這篇文章想要探討一個容易受到老師挑戰的議題,在問卷調查的研究中,若有使用量表工具來收集受訪者的心理特質時,勢必需要針對每位受訪者的回答項目,幫他們計算一個分數來代表個別的反應程度,那麼計分規則是什麼,通常會在介紹研究工具時一併交代,如下圖所示。

- 3月 15 週一 202109:42

解密Adaboost

在認識Adaboost演算法之前,我們必須了解機器學習的眾多演算法中,有一個分支是集成式學習(或稱作整體學習),但這裡有一個重要的觀念提醒,集成學習雖然歸屬於機器學習,他是一種「訓練思路」,並不是某種具體的方法或者算法。當我們使用一種分類器無法達到很良好的預測結果時,除了改使用其他類型的分類器,可以將數個分類器的預測結果綜合考慮,藉此達到分類的效果,這即是集成式學習,用白話來說就是「三個臭皮匠勝過一個諸葛亮」的概念。