- 11月 17 週一 202509:03

醫學研究使用PowerBI的情境3—醫療決策系統

- 10月 27 週一 202509:11

醫學研究使用PowerBI的情境(2)—介入措施

- 10月 20 週一 202510:40

紙本問卷鍵檔自己做(二)

三、SPSS讀取Excel檔:

- 10月 08 週三 202515:37

紙本問卷鍵檔自己做(一)

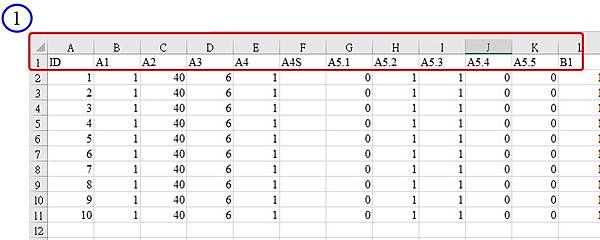

第一次進行量化研究的人,通常會選擇問卷作為研究工具,透過發放紙本問卷來回收資料,接下來就要進行鍵檔,把手邊的紙本問卷轉成電子化資料檔,以利後續的分析進行。這篇文章將舉例一些常見的題型,介紹如何製作Excel表單及鍵入規則。

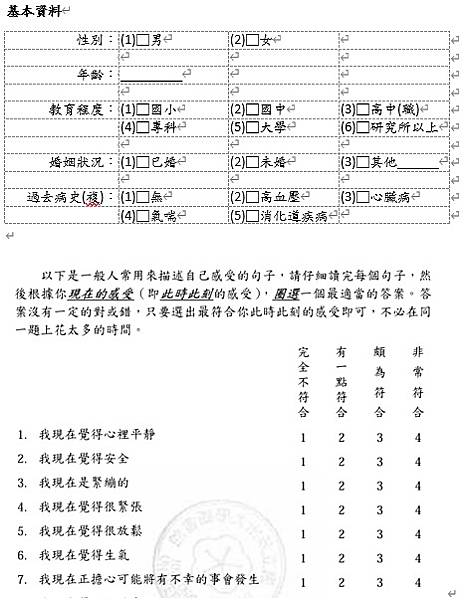

本次的示範題目包含基本資料5題,以及焦慮量表7題,格式如下圖,第一部分的基本資料題目中,性別與教育程度為單選題,代表每位受試者只能選擇一個選項,年齡為數字開放題,婚姻狀況亦為單選題,不過第三個選項其他後面附帶文字開放題,最後一題病史為複選題,代表可以選擇2項以上的選項;第二部分為量表題目,量表題型通常會共用一樣的選項,而選項數為3到7個選項不等,最常見為5個選項,選項為程度上的區別。

- 9月 22 週一 202509:20

醫學研究使用PowerBI的情境(1)—製作圖表

- 8月 18 週一 202508:53

結構方程中介分析-透過AMOS採拔靴法(Bootstrap法)(下)

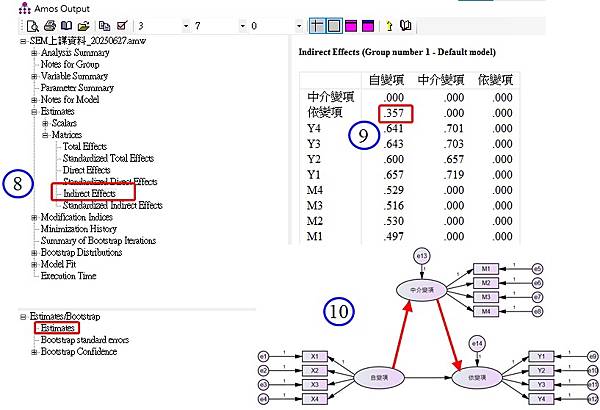

報表:

(8)相信第一次在解讀間接效果的報表時,一定非常不習慣,首先在左邊的目錄中選擇「Estimates」à「Matrices」à「Indirect Effect」,此時下方預設為「Estimates」,這裡即是間接效果的估計值,也是我們可以透過「自變項à中介變項」與「中介變項à依變項」的交乘積所計算出來,若想得到標準化的間接效果估計值,則上方必須選到「Standardized Indirect Effect」。

- 8月 04 週一 202509:14

結構方程中介分析-透過AMOS採拔靴法(Bootstrap法)(上)

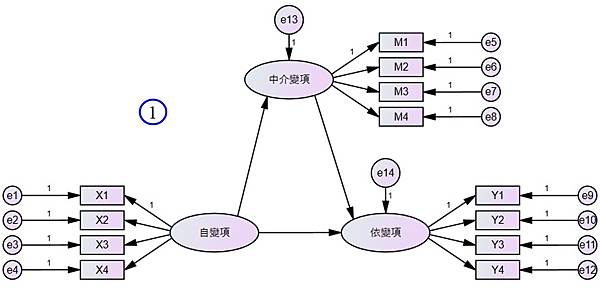

傳統的中介迴歸,是採用迴歸分析,透過Baron and Kenny(1986)提出的四個條件進行檢驗,包含:(條件1)自變項需能影響中介變項;(條件2)自變項需能影響依變項;(條件3)在自變項與中介變項聯合影響依變項之下,中介變項的影響效果要達顯著;(條件4)當放入中介變項時,自變項影響依變項的迴歸係數需要降低,為了檢驗此四個條件,在迴歸分析中必須分別進行建立三個迴歸模型分別說明條件的成立與否。但在結構方程模式中只會建立一個中介模型,因此較不適合透過上述四個條件來說明中介結果,取而代之的是,直接利用拔靴法(Bootstrap法)對於中介路徑的效果進行估計及檢驗,所謂的中介路徑,指的是兩條路徑的串聯,包含自變項影響中介變項的路徑,以及中介變項影響依變項的路徑,而中介效果(亦或稱間接效果)即是這兩條路徑係數的相乘積,最後利用拔靴法(Bootstrap法)對相乘積求得信賴區間,以檢驗中介效果的成立與否。

- 7月 18 週五 202511:25

一同研究,共同成就!

- 7月 14 週一 202511:02

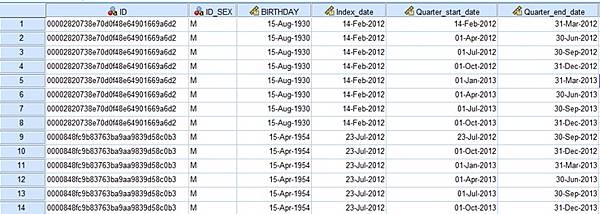

時間相依Cox model:以生物製劑對帶狀皰疹風險之影響為例

一、前言

在醫療研究領域中,許多重要的問題與事件(如中風、癌症復發、死亡)都與「時間」息息相關。傳統的 Cox 比例風險模型(Cox Proportional Hazards Model)假設暴露變項於追蹤期間維持不變,然而,現實中許多情境(如藥物使用、環境暴露)其實會隨時間變動。這時,便需使用「時間相依(time-dependent)」的存活分析方法,以避免錯誤推論。

- 6月 23 週一 202509:42

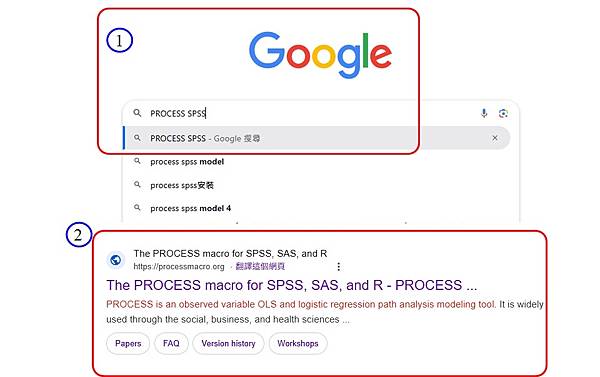

如何在SPSS裡安裝中介調節Marco: PROCESS(2025更新)

若是透過SPSS軟體進行調節分析,現階段最受歡迎的就是使用巨集Marco: PROCESS,甚至客戶每次來就直接指定說:我要跑PROESS,儼然成為中介分析的代名詞,過去文章在進行詹森內曼法的教學時(2017年),已經有提到關於PROCESS的安裝方式,過了這麼多年,才發現不但安裝的選單變了,就連下載的位置也變了,所以更新安裝說明,方便大家使用。